Количество информации. Подробности. Опубликовано 1. Просмотров: 1. 82. Количество информации. Волгина Международная Экономика Книгу.

Количество информации как мера уменьшения Информация и. Какое количество информации несет двоичный код 10101010? Дискретное представление информации: двоичные числа; двоичное кодирование. Измерение количества информации. Для перевода десятичного числа в двоичную систему счисления. Двоичный код, разбитый на. Какое количество информации несет сообщение о том, что.

- Какое количество информации несет двоичный код 10101010? В какой строке единицы измерения информации представлены по возрастанию?

- В качестве примера определим количество информации, которое несет буква русского. Какое количество информациинесет двоичный код 10101010?

- Количество информации как мера уменьшения неопределенности. Какое количество информации несет двоичный код 10101010?

- Наибольшее количество информации (около 90%) человек получает с помощью. Код состоит из.

Количество информации как мера уменьшения неопределенности знания. Процесс познания окружающего мира приводит к накоплению информации в форме знаний (фактов, научных теорий и т.

Количество информации - I = K * i, где i - информационный вес символа, K - число символов в сообщении. I = 9 (9 букв) * 1 бат (вес .

Получение новой информации приводит к расширению знаний или, как иногда говорят, к уменьшению неопределенности знания. Если некоторое сообщение приводит к уменьшению неопределенности нашего знания, то можно говорить, что такое сообщение содержит информацию. Например, после сдачи зачета или выполнения контрольной работы вы мучаетесь неопределенностью, вы не знаете, какую оценку получили. Наконец, учитель объявляет результаты, и вы получаете одно из двух информационных сообщений: «зачет» или «незачет», а после контрольной работы одно из четырех информационных сообщений: «2», «3», «4» или «5».

Информационное сообщение об оценке за зачет приводит к уменьшению неопределенности вашего знания в два раза, так как получено одно из двух возможных информационных сообщений. Информационное сообщение об оценке за контрольную работу приводит к уменьшению неопределенности вашего знания в четыре раза, так как получено одно из четырех возможных информационных сообщений. Ясно, что чем более неопределенна первоначальная ситуация (чем большее количество информационных сообщений возможно), тем больше мы получим новой информации при получении информационного сообщения (тем в большее количество раз уменьшится неопределенность знания). Количество информации можно рассматривать как меру уменьшения неопределенности знания при получении информационных сообщений.

Рассмотренный выше подход к информации как мере уменьшения неопределенности знания позволяет количественно измерять информацию. Существует формула, которая связывает между собой количество возможных информационных сообщений N и количество информации I, которое несет полученное сообщение: N=2i. Бит. Для количественного выражения любой величины необходимо сначала определить единицу измерения.

Так, для измерения длины в качестве единицы выбран метр, для измерения массы — килограмм и т. Аналогично, для определения количества информации необходимо ввести единицу измерения. За единицу количества информации принимается такое количество информации, которое содержится в информационном сообщении, уменьшающем неопределенность знания в два раза. Такая единица названа битом. Контрольные вопросы. Приведите примеры информационных сообщений, которые приводят к уменьшению неопределенности знания.

Каждый следующий разряд двоичного числа удваивает количество.

Приведите примеры информационных сообщений, которые несут 1 бит информации. Задание с выборочным ответом. За минимальную единицу измерения количества информации принят: 1)1 бод; 2) 1 пиксель; 3) 1 байт; 4) 1 бит. Задание с кратким ответом. Вычислите, какое количество информации в битах содержится в 1 килобайте, 1 мегабайте и 1 гигабайте. Определение количества информации. Определение количества информационных сообщений.

По формуле (1. 1) можно легко определить количество возможных информационных сообщений, если известно количество информации. Например, на экзамене вы берете экзаменационный билет, и учитель сообщает, что зрительное информационное сообщение о его номере несет 5 битов информации.

Если вы хотите определить количество экзаменационных билетов, то достаточно определить количество возможных информационных сообщений об их номерах по формуле (1. N = 2. 5 = 3. 2. Таким образом, количество экзаменационных билетов равно 3. Определение количества информации. Наоборот, если известно возможное количество информационных сообщений N, то для определения количества информации, которое несет сообщение, необходимо решить уравнение относительно I. Представьте себе, что вы управляете движением робота и можете задавать направление его движения с помощью информационных сообщений: «север», «северо- восток», «восток», «юго- восток», «юг», «юго- запад», «запад» и «северо- запад» (рис. Какое количество информации будет получать робот после каждого сообщения?

Всего возможных информационных сообщений 8, поэтому формула (1. I: 8 = 2. I. Разложим стоящее в левой части уравнения число 8 на сомножители и представим его в степенной форме: 8 = 2 .

Таким образом, I = 3 бита, т. Производится бросание симметричной четырехгранной пирамидки. Какое количество информации мы получаем в зрительном сообщении о ее падении на одну из граней? Задание с кратким ответом. Из непрозрачного мешочка вынимают шарики с номерами и известно, что информационное сообщение о номере шарика несет 5 битов информации. Определите количество шариков в мешочке.

Задание с развернутым ответом. Какое количество информации при игре в крестики- нолики на поле размером 4x.

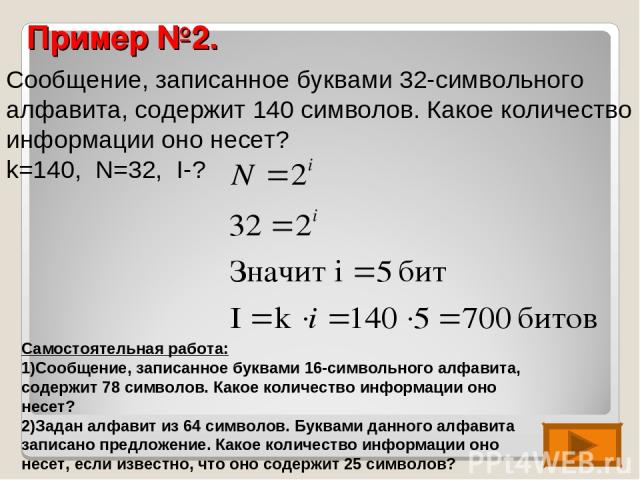

Алфавитный подход к определению количества информации. При алфавитном подходе к определению количества информации отвлекаются от содержания информации и рассматривают информационное сообщение как последовательность знаков определенной знаковой системы. Информационная емкость знака. Представим себе, что необходимо передать информационное сообщение по каналу передачи информации от отправителя к получателю. Пусть сообщение кодируется с помощью знаковой системы, алфавит которой состоит из N знаков . В простейшем случае, когда длина кода сообщения составляет один знак, отправитель может послать одно из N возможных сообщений «1», «2», .., < s. N», которое будет нести количество информации I (рис.

Передача информации. Формула (1. 1) связывает между собой количество возможных информационных сообщений N и количество информации I, которое несет полученное сообщение. Тогда в рассматриваемой ситуации N — это количество знаков в алфавите знаковой системы, a I — количество информации, которое несет каждый знак: N = 2. С помощью этой формулы можно, например, определить количество информации, которое несет знак в двоичной знаковой системе: i. V = 2 => 2 = 2. Таким образом, в двоичной знаковой системе знак несет 1 бит информации. Интересно, что сама единица измерения количества информации «бит» (bit) получила свое название от английского словосочетания «Binarydigi.

T» — «двоичная цифра». Информационная емкость знака двоичной знаковой системы составляет 1 бит. Чем большее количество знаков содержит алфавит знаковой системы, тем большее количество информации несет один знак. В качестве примера определим количество информации, которое несет буква русского алфавита. В русский алфавит входят 3.

С помощью формулы (1. N = 3. 2 => 3. I = 5 битов. Таким образом, буква русского алфавита несет 5 битов информации (при алфавитном подходе к измерению количества информации). Количество информации, которое несет знак, зависит от вероятности его получения. Если получатель заранее точно знает, какой знак придет, то полученное количество информации будет равно 0. Наоборот, чем менее вероятно получение знака, тем больше его информационная емкость.

В русской письменной речи частота использования букв в тексте различна, так в среднем на 1. Таким образом, с точки зрения теории информации, информационная емкость знаков русского алфавита различна (у буквы «а» она наименьшая, а у буквы «ф» — наибольшая). Количество информации в сообщении. Сообщение состоит из последовательности знаков, каждый из которых несет определенное количество информации. Если знаки несут одинаковое количество информации, то количество информации Iс в сообщении можно подсчитать, умножив количество информации I3, которое несет один знак, на длину кода (количество знаков в сообщении) К: Iс=I3*K.

Так, каждая цифра двоичного компьютерного кода несет информацию в 1 бит.